Un sujet récurrent dans mes conversations avec mes clients se trouve être l’indexation. Vous le savez, avoir un site avec des milliers de pages ne sert à rien si elles ne sont ou ne peuvent être indexées.

J’ai personnellement pour habitude de surveiller l’indexation d’un site. A quoi bon me disent certains clients, Google finira bien par trouver ma page. Malheureusement c’est un peu plus complexe que ça.

Je précise avant d’entrer dans le vif du sujet que ce qui suit n’engage que moi et est issu de mon expérience. Je vous laisse vous faire votre propre opinion.

Ma théorie c’est meilleure indexation = meilleur référencement = meilleure visibilité.

Jusque là je pense que tout le monde sera d’accord, du moins je l’espère.

Mais bon, indexation késako? Comment ça fonctionne? Puis-je l’influencer?

Vérifier l’indexation de son site

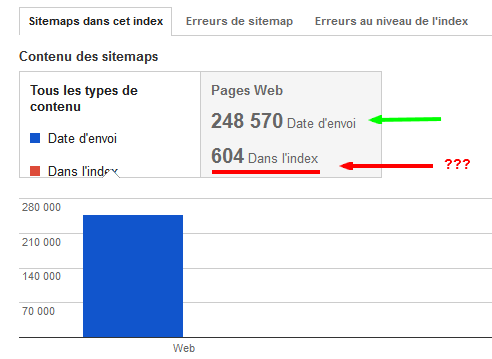

Pour cela plusieurs options. Si vous utilisez Le Google Webmaster Tool (GWT) et que vous lui avez indiqué un joli sitemap au format xml vous avez déjà un bel aperçu comme on peut le voir ci-dessous.

On peut voir ci-dessous deux cas extrêmes: à gauche une très bonne indexation même si elle n’est pas parfaite et à droite une indexation que je qualifierais de catastrophique.

Ce n’est qu’une méthode pour vérifier le taux d’indexation d’un site, mais il en existe d’autres. Certains outils font cela de manière automatique mais également des scripts persos. A vous de voir quelle solution vous préférez.

Une autre relativement simple qui ne demande aucun outil, c’est la comparaison du nombre de résultats retournés par google pour votre site avec la commande « site: » et le nombre d’url dans votre sitemap.

Pour cela rien de sorcier, rendez-vous sur google et tapez la requête site:votrendd.fr. Ou mieux, utilisez la petite astuce que je vous ai donné dans mon article sur les raccourcis SEO. Il suffit ensuite de comparez le nombre de résultats avec votre nombre d’URL réelles déclarées indexables.

Est-ce vraiment important d’avoir un fort taux d’indexation? Je vous répondrais la même chose qu’à mes clients, il faut considérer chacune de vos pages comme une porte d’entrée pour les visiteurs sur votre site. La page est indexée, super la porte est ouverte allons voir ce qui se passe. la page n’est pas indexée c’est donc une porte fermée qui ne laissera jamais entrer un seul visiteur issu du référencement naturel.

Donc à présent on connait le problème et son importance sur notre site. Mais comment en trouver la cause?

Pourquoi mes pages ne sont-elles pas indexées sur Google?

Là encore, ne cherchez pas la réponse unique elle n’existe pas. Les causes peuvent être aussi diverses que variées voire même multiples pour une seule page.

Sans faire un listing exhaustif voici quelques cas récurrents que nous sommes amenés à rencontrer:

- Déclaration de non indexation: dans votre robots.txt avec un joli disallow par exemple ou encore avec la meta robots Noindex . Ne rigolez pas, j’ai eu le cas d’un site client qui se désindexait vitesse grand V pour la simple et bonne raison que le développeur avait rajoutez un disallow: / ^^

- Contenu dupliqué: soit interne avec un même contenu repris sous plusieurs URL (cf la conférence du VLC2012 et les pages catégories, tag, auteur sur WordPress par exemple…) mais également externe. Si un site indélicat et hyper trusté s’amuse à reprendre le contenu de votre page, Google aura vite fait son choix entre un site LeMonde et votre site fraichement sortie du moule le mois dernier. (Attention je n’ai pas dit que lemonde pompait le contenu 😉 )

- Page orpheline: Votre page peut contenir le texte le plus pertinent sur un sujet mais si elle n’est linkée de nul part google ne trouvera pas cette page et donc ne l’indexera pas. D’où l’intérêt d’un maillage interne intelligent.

- …

Pour revenir sur le dernier point, un outil que j’utilise régulièrement c’est Xenu, il est une mine d’informations pour peu que l’on prenne le temps d’exploiter un peu les données brutes qu’il nous remonte.

En deux mots Xenu vous rapporte:

- l’url crawlée

- son statu (404, 301, 302 200…)

- Le tilte de la page

- le niveau de votre page dans la hiérarchie de votre site; Au delà de 4 cela risque de se compliquer

- OBL ou nombre de liens sortants

- In links nombre de lien entrant

Pour l’indexation d’un site il est intéressant de regarder le statu de la page, le title si plusieurs fois le même title dans le listing vous avez possiblement du DC, le nombre de liens entrants; Si égal à 0 c’est une page orpheline liée nul part…

Mais indexé n’est pas joué!!!

En effet, avez-vous déjà entendu parler de l’index primaire et secondaire de Google?

Avec un résumé simpliste, google n’est pas constitué d’un seul index mais de plusieurs.

On retrouve l’index global, c’est celui-qui est interrogé quand vous faites la commande site:votrendd.fr par exemple

Il existe un index primaire et un index secondaire.

Mais qu’est-ce que tu me racontes là Doudou dis donc!!!

Vous vous demandez probablement où on les trouve ces espèces, à part la réponse favorite de notre célèbre Nikolittlestar il suffit de les interroger et de fonctionner par déduction.

Pour être concret, vous avez probablement remarqué certaines fois lors d’une « requête site: » ce genre de réponse en fin de liste:

En gros, Google vous dit clairement qu’il connait d’autres résultats pour votre site mais qu’il les a volontairement laissé de côté pour cause de contenu trop similaire. Tiens donc, mais c’est que ça pourrait nous servir ça!!!

C’est là que les deux index prennent tout leur sens. L’index primaire de Google ne recense que les url de votre site qu’ils considèrent d’une qualité suffisante, ou du moins suffisamment différenciées pour y apparaitre. L’index secondaire, c’est un peu la voie de garage où certaines de vos url sont placées. Autant vous dire que ces dernières n’auront que très peu de chance de ressortir sur des requêtes d’internaute.

Pour identifier combien et quelles urls sont dans quel index voici la solution:

- site:votrendd.fr ici nombre d’url dans l’index global de Google

- site:votrendd.fr/& ici nombre d’url dans l’index primaire de google

- pour connaitre celles de l’index secondaire site:votrendd.fr -site:votrendd.fr/&

Avant que certains me tombent dessus, il y a quelques semaines il fallait utiliser le # au lieu du &. Seulement google a coupé et l’ancienne méthode ne fonctionne plus. Avec cette dernière on obtient des résultats un peu différents de la précédente, mais c’est toujours mieux que rien.

Mon point de vue là dessus, c’est que vous devez tendre vers:

- 100% de vos url indexées

- 100% de vos url indexées dans l’index primaire de Google

- 0% de vos url dans l’index secondaire

Rassurez-vous, ce n’est qu’un objectif à viser, mais plus vous en serez proche et mieux votre site se portera.

Quelques pistes pour vous approcher de ce Saint Graal:

- Toujours créer des pages avec suffisamment de contenu différent et pertinent (ex des fiches produits pour un même article ou simplement la couleur change…)

- Faites la chasse au DC

- Posez-vous la question de l’utilité de faire indexer une page ou non. (page panier, formulaire de contact…)

- …

Voila un petit topo sur l’indexation que je souhaitais rédiger depuis un petit bout de temps. Rien de révolutionnaire, mais ça me tenait à coeur surtout que certains m’avaient posé des questions là dessus. Maintenant je pourrais simplement faire un lien vers mon billet 🙂

Il est clair qu’une page présente dans l’index secondaire de Google est à considérer comme « faible » et doit être améliorée. Et les outils pour webmaster donnent de plus en plus d’indications à ce sujet.

Ton article explique bien la méthodologie à suivre pour une prise en compte à 100% de ses pages, j’ajouterais juste un petit ping pour alerter GG sur les pages nouvellement créées ou mises à jour, et puis surtout, un gros ping sur le sitemap (« renvoyer le sitemap »). Même si on peut penser que ce fichier est anecdotique, je le re-soumets à chaque modification d’une des pages de mes clients et ça booste l’indexation 😉

Une question d’un débutant. Les résultats qui montrent une URL puis 3 autres URL plus petites du même site en dessous sont des pages de l’index secondaires ?

Pour mon cas, c’est le tutoriel que j’ai rédigé sur le sdz (voir mon dernier article). Le tuto qui ressort est nul mais vieux.

J’ai l’impression que la récente indexation de mon tuto joue négativement. Donc faut que je fasse du lien pour changer la donne et ainsi montrer à Google que c’est ma page qu’il doit afficher.

Dommage que Google ne nous disent pas les pages qui sont dans l’index secondaire.

Un pt’i tuto sympa pour ceux qui ne connaissait pas les différents index de google.

Tiens ça me fait penser que l’on peut se monter facilement un outil d’audit seo (dont le check d’indexation) via excel en utilisant xpath 😉

D’ailleur il me semble que les moteurs de recherche des FAI (orange, sfr…) mettent en avant l’index primaire et secondaire.

C’est pourquoi certaine personne n’utilisant que ces moteurs de recherche (si si ça existe ;)) ne vois pas tout à fait les mêmes résultats que nous. Ce sont d’ailleur généralement les seniors mais quand on fait un site qui cible cette catégorie d’internaute il vaut mieux faire attention 😉

Je trouve ce Tuto très clair comme toujours. J’adore votre blog car vous avez le talent de rendre des choses plutôt difficile à expliquer très simple et clair.

Cela me permet vraiment d’avoir un discours toujours plus précis et clair auprès des clients, qui pour la plus part pense que le référencement c’est deux trois truc vite fait…

Encore merci pour l’énergie que vous déployez pour transmettre vos connaissances.

Je ne savais pas qu’il y avait diffèrent types d’index.

J’avais cependant remarqué le petit lien en bas de page de recherche pour afficher plus de résultat.

Par contre ce que j’avais trouvé bizarre, c’est que sur un site j’ai dans mon robots.txt la ligne Disallow: /author

Mais google m’indexe quand même la page /author/admin/

Après cette page est affichée que quand je clique sur le lien « Inclure les pages ignorées »

Un article intéressant !

Xenu qui est cité reste (après plusieurs années) un outil à garder sous le coude pour tout audit sérieux.

Mode j’aime : j’adore le titre « indexé n’est pas joué!!! », bravo ! …

Je me permets de corriger un peu les explications concernant le ratio pages fournies / pages indexées dans le sitemap. Le robots.txt ne contient pas de « Déclaration de non indexation » mais de non crawl.

La non indexation se fait par les meta robots noindex.

Enfin, concernant les raisons évoquées d’un décalage URL fournies/indexées, il faut aussi ajouter les rel canonical 😉

En tout cas l’article est intéressant !

Concernant l’index primaire / secondaire, cette commande est elle réellement fiable ? D’où la tires tu ?

Un très bon billet, j’ai envie de dire comme d’hab ^^. Sinon avez vous une idée de la fréquence des updates de GWT ? Car pour l’analyse de lien j’ai pas l’impression que ca soit top en fraicheur. D’ailleurs je trouve que le plus rapide (peu pertinent) c’est Alexa.com …

@Yann j’avais encore de nombreuses choses à dire mais déjà là 1250 mots je trouve que c’est beaucoup à lire

@lereferenceur non ça n’a rien à voir Gg peut proposer plusieurs résultats d’un même site pour une requête

@guillaume le blocage par robots.txt n’est pas du tout infaillible il est clairement dit que google peut choisir d’indexer une page bloquée pour le crawl si des liens pertinents pointent vers cette dernière

@Joséphine xénu j’ai pas trouvé mieux pour le moment

@François pas tout à fait d’accord mettez un disallow:/ dans votre robots.txt et on regarde si google se contente simplement de ne pas crawler 😉 mais sur le principe vous avez raison. j’ai précisé dans l’article url soumise à l’indexation. Je suis partisan de la non utilisation de la rel canonical qui n’est qu’une rustine mais c’est un autre débat

@Simon il existe une certaines latence entre les données réelles, et les données affichées sur GWT. mais honnêtement je ne me suis jamais posé la question de la fréquence.

Oui je savais qu’il pouvait indexer plusieurs pages d’un meme site mais apres je ne m’etais jamais posé la question de savoir si les autres resultat pour un meme site affiché en petit en dessous, etait des pages de l’index primaire ou de l’index secondaire.

Merci pour ta réponse.

Xenu ne fonctionne de mémoire que sur PC, ce qui, pour nous, en limite l’intérêt.

Je ne sais pas si cela fonctionne encore, mais quand tu regardais les résultats sous AOL, il n’y avait que l’index « dit » primaire.

Par contre, certains référenceurs doutent de l’existence de deux indexs.

C’est effectivement compliqué de savoir s’il s’agit d’un deuxième index ou d’un filtre dynamique, ou autre, ce d’autant que les résultats varient selon les moments…

Très bonne présentation des principaux outils et commandes pour s’assurer de la bonne indexation de ses pages !

Comme toi j’utilise principalement Xenu et GWT pour voir si tout se passe bien, c’est peut-être d’ailleurs le principal avantage à fournir à Google un sitemap XML bien réalisé car cela permet de comparer ce qui devrait être indexé de ce qui l’est vraiment.

Je me sers également de l’onglet « Liens internes » dans GWT (en plus de Xenu) pour détecter les faiblesses du maillage interne d’un site.

Bref, des articles comme ça j’en veux tous les jours Raph :p

Excellente piqûre de rappel, qui est d’autant plus valable si l’on compte sur la longue traîne pour créer du trafic! + de pages = + de KW = + de visites.

Ce conseil sur l’indexation est également valable pour ses backlinks. Plus vite ils seront repérés par google et plus vite ils auront du poids. On peut l’aider un peu en utiliser des sites de ping comme Linklicious.

« mettez un disallow:/ dans votre robots.txt et on regarde si google se contente simplement de ne pas crawler »

Fais également le test : laisse s’indexer du contenu. Ne place aucune noindex, ne demande aucune suppression d’URL dans Webmaster Tools et ajoute juste un Disallow: * dans le robots.txt

Rien ne sera désindexé. 🙂

Mais c’est un autre débat.

Pour la canonique, beaucoup disent ça mais utilisée à bon escient c’est un outil redoutable pour l’optim on site 🙂

A c’est clair avoir des urls en index secondaire c’est signe de boulette enfin sauf si vous en avez une ou deux mais si vous commencez à en avoir pas mal c’est que vous avez un souci, duplicate de title, de description, pas assez de contenu,…

Par contre un truc que je ne comprendrais jamais et la faut vraiment m’expliquer pourquoi ne voulez vous pas faire indexer une page contact.

Déjà la page contact contient presque toujours des informations importantes pour le robot (téléphone, adresse, map) et pour l’internaute c’est quand même bien plus cool pour lui de pouvoir avoir accès direct via Google à la page contact.

Je pense que vous oubliez le coté humain car j’ai déjà entendu plus d’une fois de la part de personnes qui surfent, loin des grands gourous du web market ou web seo, me dire : « si je tape contact + nom de société et que je trouve pas la page contact ( comprendre en lien direct), ça sent l’arnaque je trace »

En plus c’est quand même pas si complexe de mettre un peu de contenu dedans et même pour une boutique en ligne.

Enfin ça reste mon avis…

Je ne sais pas pour vous mais la commande pour connaitre le nombre d’url de l’index secondaire me renvoie un chiffre théorique de résultats identique au nombre d’url total. Ce qui paraît incohérent. En parcourant l’ensemble des résultats de l’index secondaire, il y a en fait beaucoup moins de résultats que le nombre annoncé par le moteur de recherche.

Concernant Xenu, c’est un très bon outil et qui est gratuit par contre non compatible avec Mac.

Sinon l’astuce pour le & à la place du # est intéressante, tu es tombé dessus par hasard?

PS: Tu as fait une petite faute de frappe sur statu ;).

Très bon article qui permet aux personnes non-initiées de mieux comprendre l’intérêt de l’indexation et les outils mis à leur disposition afin de s’améliorer.

@Christian: Xenu ne fonctionne effectivement que sur PC mais Site Orbiter est une bonne alternative sous mac: gratuit, il permet de générer une cartographie représentant les diverses relations entre les pages du site (liens entrants/sortants etc)

Merci pour cet article très clair. Une petit question cependant pour un non-initié : quand on a un gros écart entre le nombre d’URL indexées (le graphique) et le nombre de l’index global (site:votrendd.fr) cela peut-il venir du fait que beaucoup de PDF soient indexés par Google même s’il ne sont pas présents dans le sitmap fournis ?

Excellent article

Dans la pratique, on se rend tout de même compte qu’il est presque plus facile de voir ses pages indexées que le contraire.

Le robots.txt est une rustine assez inefficace, seul ne noindex limite les dégats, et encore, dans certains cas seul le cloaking fonctionne encore.

Au passage, j’ajouterai quand même que je ne suis pas forcément fan de la volonté de désindexation à tout crin. Les mentions légales, pages de contact et autres pages « secondaires » peuvent être des pages intéressantes à faire indexer, il suffit juste de les remplir de manière à les rendre « sexy » et utiles à l’internaute.

@Fausine

En effet, il y a des alternatives sous Mac. Je n’ai pas encore essayé Site Orbiter par contre.

Je me suis développé mon propre tool desktop pour scanner les sites, quand il me manque une fonctionnalité, je la rajoute, et hop !

@Raph : ton serveur fait beaucoup d’erreur 500

J’ai l’impression que la commande pour obtenir les pages de l’index secondaire ne fonctionne pas.

La commande site:https://www.visibilite-referencement.fr -site:https://www.visibilite-referencement.fr/ me donne le même résultat [247] que site:https://www.visibilite-referencement.fr

C’est moi ou j’ai zappé quelque chose ?

il ne faut pas le faire directement dans google mais relever les résultats de chacune des requêtes et faire un comparatif 😉

Avec les www ça ne marche pas, recommence sans et ça devrait fonctionner.

J’ai souvent vu ce message google disant qu’il a ignoré des pages dans les résultats qu’il donne mais je n’ai jamais réfléchi à ce qu’il y avait derrière, ce fameux deuxième index. Il va falloir que je me penche sérieusement sur le sujet et faire ces petits tests.

En plus du fait que chaque page est une porte d’entrée il faut rapeller que plus un site est gros et plus il a tendance a se positionner – j’utilise souvent une analogie avec les bouquins – si yu es dans une biblitheque et que tu cherche un bouquin sur le SEO – tu auras tendance a tourer lequel plus pertinent – le bouquin de 200/250 pages ou bien le petit flyers de 10 pages? (bon aors apres c’est pas toujours possible mais bon).

Euh sinon raph tu ne donnes pas les soluces pur quand ton site est pas indexé –

Vérifier son Robots.txt et permettre le crawl

Verifier ses meta robots – mettre en index, follow – ou virer les meta robots

Verifier son htaccess (et oui des fois ca chie a ce niveau)

Vérifier qu’il n’y a pas de Java Script tout pourri (genre mise en place de cookie) qui empeche le crawl si il n’est pas accepté(cas concret)

mettre en place un sitemap.xml et aussi un sitemap.html qui tienne la route

Salut,

Résumé simple mais efficace, je bookmark pour filer aux clients ^^.

Je découvre ce blog, good one 😉

@francois: la canonical est selon moi du temps perdu. Jamais trouver d amélioration dans mes différents tests. À voir avec les gourous SEO.

Je re

Avec une relecture au calme et un peu de recul je trouve vraiment l’article excellent !

Une bonne piqûre de rappel comme le dit Axel.

J’ajouterai encore les remarques suivantes (qui peuvent avoir une influence sur l’indexation et le positionnement des contenus) :

– varier les mises en page

– varier les médias inclus dans vos articles : img, audio, vidéos etc …

Il semble également que Google puisse indexer des liens saisis dans le navigateur lorsque la Google barre est installée. Cas observé sur un site en construction alors que les pages indexées n’étaient pas liées à l’index.

C’est sympa de trouver des articles qui expliquent simplement les petites nuances qu’on ne connait pas spécialement. C’est vrai que quant on y réfléchit, si une page a pas de liens, google ne peut pas la trouver donc on peut toujours chercher dans les résultats on comprend pourquoi elle n’est toujours pas la !

Je rebondis sur la réponse du Juge :

« Vérifier qu’il n’y a pas de Java Script tout pourri (genre mise en place de cookie) qui empeche le crawl si il n’est pas accepté(cas concret) »

C’est en effet très vicieux surtout quand la page s’affiche correctement mais génère une erreur 304 que le WMT ne remonte pas lors d’un test de crawl (cas concret aussi lors du lancement d’un site).

Dans le résultat du test de crawl, vous aurez une entête http avec un code 200 mais un beau « Content-Length: 0 » et bien entendu pas une ligne de code html affichée ni indexée au lancement de votre site.

Parfois il y a des développeurs qui aiment bien faire des blagues aux SEO 😉

J’eus travaillé auparavant sur des sites de taille importante, coté développement, et même si je ne prends pas en charge le référencement, je m’assure tout de même d’une accessibilité optimale : autant te dire que les bonnes pratiques que tu évoques sont dans le cas de site de grande ampleur tout bonnement OBLIGATOIRES à mettre en place, sous peine de se retrouver avec un trafic web largement en deçà de ce qu’il devrait être.

Bravo en tout cas, car au moins, je n’oublierai à l’avenir plus rien, juste en bookmarkant ton article 😀 !

Est-ce grave si j’ai des erreurs dans GWT? J’ai des URL introuvables listées automatiquement que je n’arrive pas à enlever…

bonjour,

merci pour cet article que je trouve intéressant il va vraiment m’aider à améliorer ma visibilité sur internet

Bel article qui donne le cocktail idéal d’un site explosif: un bon sitemap à surveiller sur GWT pour indexer la plus longue traîne possible avec quelques mesures de Xenu pour surveiller le contenu le moins dupliqué possible. Et quelques gouttes de Ping pour chaque nouvelle page à indexer. L’index, un souci majeur!

Nous avons choisi un tumblr pour notre projet de blog et le moins que l’on puisse dire c’est que c’est une vraie daube niveau référencement.

Merci pour l’article on va tenter de se faire indexer plus de pages.

Un très bon article. Des outils comme GWT c’est super car gratuit, mais encore faut-il pouvoir interpréter les résultats fournis!